优化系统性能与资源利用的负载均衡技术探索

分类:杂谈

日期:

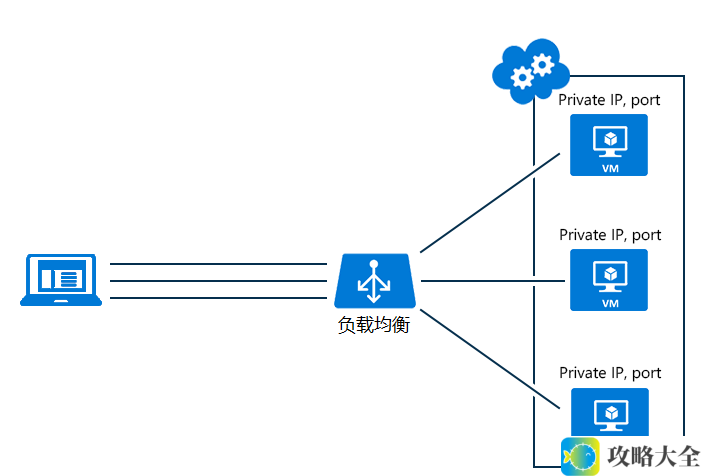

负载均衡(Load Balance)在软件开发和运维领域中占据了重要位置,其核心目的是通过合理的资源分配,提高系统的性能、可靠性和可扩展性。下面将详细讨论负载均衡的定义、工作原理、不同类型、实现方式以及应用场景。

一、定义

负载均衡是一种技术,旨在将网络或计算资源上的工作任务、访问请求等均匀分配到多个操作单元(如服务器、CPU、磁盘驱动器)上,以优化资源使用、最大化吞吐量、最小化响应时间并避免系统过载。

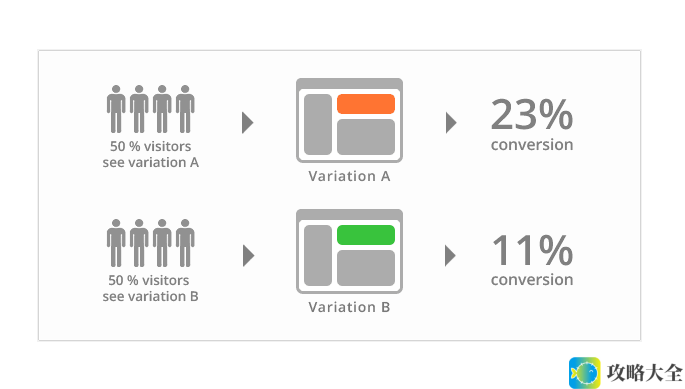

二、工作原理

负载均衡通过特定的算法和策略将接收到的请求分发到不同的资源上。常见的算法包括轮询(Round Robin)、最少连接(Least Connections)、加权轮询(Weighted Round Robin)、IP哈希(IP Hash)等。这些算法确保负载分配的动态调整,从而保持系统的稳定性和性能。

三、类型

负载均衡根据应用场景和部署方式可以分为几种类型:

- 本地负载均衡:适用于同一地理位置的服务器群,解决数据流量大或网络过载的问题。

- 全局负载均衡:适用于不同地理位置和网络结构的服务器群,以提升用户的访问速度和体验。

- 硬件负载均衡:通过专门的负载均衡设备实现,如F5等,通常具有高性能和高可靠性。

- 软件负载均衡:通过如Nginx和HAProxy等软件实现负载均衡功能,易于配置和扩展。

四、实现方式

负载均衡的实现方式多种多样,包括:

- DNS负载均衡:基于DNS解析将用户请求分发至不同的服务器。

- 反向代理负载均衡:用户请求通过反向代理服务器分发至后端服务器,可实现复杂的负载分配策略。

- IP层负载均衡:在网络层修改数据包目的地址进行请求分发,适用于大型网络。

- 应用层负载均衡:解析应用层协议进行请求分发,实现更加精细的负载策略。

五、应用场景

负载均衡广泛应用于需要处理大量并发请求的场景,例如:

- Web服务器集群:将用户请求分发至多个Web服务器,提升网站访问速度和稳定性。

- 数据库集群:将数据库查询请求分发至多个服务器,从而提高查询性能。

- 文件服务器集群:优化文件传输速度,通过负载均衡处理多个请求。

- 微服务架构:在微服务环境中,分发服务调用请求至不同实例,实现高可用性。

负载均衡的实现与管理无疑是现代网络架构中必不可少的一环。在具体实施中,选择适宜的策略和工具可大幅提升系统的处理能力和用户体验。

问题解答:

1. 负载均衡的主要目的是什么?

主要目的是优化资源使用、最大化吞吐量、最小化响应时间并避免系统过载。

2. 负载均衡有哪些常见的实现方式?

常见的实施方式包括DNS负载均衡、反向代理负载均衡、IP层负载均衡和应用层负载均衡。

3. 在哪些场景中负载均衡比较重要?

负载均衡在Web服务器集群、数据库集群、文件服务器集群和微服务架构等场景中尤为重要。